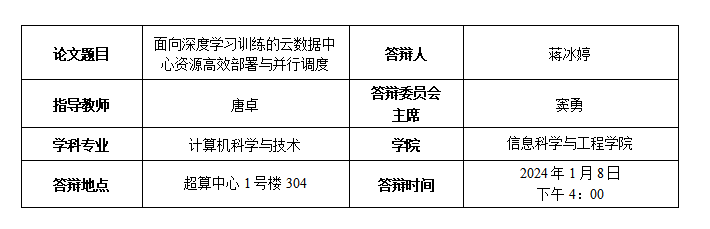

学位论文简介

随着深度学习模型复杂性的日益增加,相应的计算需求也呈现指数级增长。尤其是在训练过程中模型需要对大量的数据进行特征提取,并经过多轮的迭代参数梯度更新得到最终模型,这是一个计算密集且耗时的过程。面对这样的计算挑战,GPU 等高性能计算设备已成为深度学习的核心加速器。在深度学习、科学计算和复杂数学模型求解等领域,GPU 凭借其数千核心的并行处理能力与 CPU 的复杂计算能力相辅相成,成为当前主流的计算工具。传统的高性能计算依赖于以 CPU 为核心的集群架构,但随着 GPU 计算能力的显著增强,越来越多的高性能云数据中心开始采用 GPU 与 CPU 并行部署的策略,从而为各类应用提供更加强劲和高效的计算支持。

为了更有效地利用数据中心丰富的计算资源,面向多租户的大规模配备 GPU 的云数据中心已逐渐演变为深度学习研究和商业应用的关键基础设施。然而,要充分挖掘数据中心资源的潜力并确保其运行效率,综合的优化策略尤为重要。在这样的计算密集型环境中,如何有效地进行资源部署和调度,成为了云数据中心高效计算的核心问题。本研究着眼于深度学习背景下的大规模计算需求,从数据中心的快速部署、GPU 资源的并发调度,到面向深度学习任务的资源分配策略三个层面,进行了广泛而深入的探讨和优化。本文的主要工作研究成果如下:

在数据中心底层的基础设施中,研究了大规模云资源池快速部署架构。针对金融危机等突发的公共安全事件瞬时爆发的大规模计算需求,该研究采用智能分布式镜像仓库服务部署架构 (IDRD),快速构建了计算、内存、网络资源池并统一对外提供弹性算力的大规模集群。IDRD 基于 OpenStack 云平台,采用多个分布式放置的仓库进行容器化部署,并提出了一种服务器负载优先算法来解决其中的多仓库的放置问题。在此基础上,该研究设计了一种基于需求密度的聚类算法,可以进一步优化 IDRD 的全局性能,提高大规模集群的负载均衡能力。IDRD 在天河超级计算环境中进行了大量实验表明,其显著地减少了 OpenStack 组件镜像分发时间,并极大地提高了数据中心的部署效率。

在数据中心资源调度层,研究了 GPU 内核的并发调度机制。针对数据中心 GPU 任务混合并发执行的场景,该研究设计了动态资源感知流和混合内核切片并发架构 (DRASTIC),充分利用了 GPU 资源提高了 GPU 并行计算的能力。DRASTIC 通过分析内核的操作特性将内核进行切片配对执行,并根据当前资源的空闲情况,动态的进行内核到 CUDA 流的分配,以提高内核并发性。针对不同的内核执行模式,该研究提出了多种算法来调度多个混合内核切片和 CUDA 流。在此基础上,该研究设计了 CPU 主机到 GPU 设备之间的内核数据分块并行传输和内核统一管理的两个系统级优化方案。DRASTIC 在英伟达 (NVIDIA) Tesla GPU 上进行的大量实验表明,其显着提高了 GPU 内核任务的执行效率,并极大提高了数据中心的 GPU 任务整体执行性能。

在数据中心资源应用层,研究了 GPU 资源分配调度策略。针对数据中心来自多个租户的大量深度学习训练任务的资源需求,该研究提出了以任务资源的公平性和集群的总体效率为目标调度架构 Dike,在给定任务所需资源的同时进行通信感知的任务放置提升执行效率。Dike 利用离散的混合优先级反馈队列,优先处理较小的任务以加速任务的总体完成时间,同时为大型任务提供不间断的资源以保证资源的公平分配。这些训练任务通常采用分布式技术进行加速,该研究提出了一种通讯感知任务放置策略,在深度学习模型分布式训练时进行了通信优化。Dike 基于微软的 Philly 共享集群深度学习任务跟踪数据,模拟了大规模数据中心资源调度流程,实验表明其显着提高了集群总体作业完成效率和公平性,并极大地提高了数据中心深度学习训练任务的执行效率。

主要学术成果

Bingting Jiang, Zhuo Tang , Xiong Xiao, Jing Yao, Ronghui Cao, Kenli Li. Efficient and Automated Deployment Architecture for OpenStack in TianHe Super Computing Environment. IEEE Transactions on Parallel and Distributed Systems (TPDS, CCF A类). 2022.

Zhuo Tang, Bingting Jiang, Yaohua Wang, Yuanchun Liu, Kenli Li. Improving GPU Performance via Coordinated Kernel Slicing and Multi CUDA Streaming. Design Automation Conference 2022 (DAC, CCF A类).

Xiong Xiao, Zhuo Tang, Chuanying Li, Bingting Jiang, Kenli Li. SBPA: Sybil-based Backdoor Poisoning Attacks for Distributed Big Data in AIoT-based Federated Learning System. IEEE Transactions on Big Data (TBD, SCI 2区). 2022.